EADTrust anuncia su servicio de Evaluación de uso de la criptografía y preparación de plan de acción para adoptar la Criptoagilidad, que conlleva la Resistencia a la Computación Cuántica (QRC), para empresas y organismos públicos, ante la prevista llegada de computadores cuánticos que podrán aplicar el algoritmo de Shor (o el de Grover) a los sistemas de cifrado y de firma electrónica.

En un mundo cada vez más digitalizado, en el que los datos son el activo más valioso de las empresas, la llegada de la computación cuántica representa tanto una oportunidad revolucionaria como una amenaza inminente. Como consultor en confianza digital y fundador de EADTrust, he seguido de cerca los avances en este campo, y recientemente hemos lanzado un nuevo servicio de consultoría especializado en el análisis de riesgos cuánticos en criptografía para empresas.

Este servicio no solo evalúa las vulnerabilidades actuales, sino que también proporciona un «roadmap» claro para transitar hacia la adopción de una criptografía post-cuántica (PQC), asegurando la resiliencia de los sistemas en un futuro próximo.

Este tipo de iniciativas de consultoría y evaluación, sin duda será impulsado de forma similar por las grandes consultoras, pero una de las diferencias es que EADTrust puede proporcionar «bloque constructivos» para incorporar a las infraestructuras de las empresas, por su rol de Prestador Cualificado de Servicios de Confianza.

Ya el año 2025 ha sido bautizado como el «año de la cuántica»: la Asamblea General de las Naciones Unidas lo proclamó oficialmente como el Año Internacional de la Ciencia y la Tecnología Cuánticas (IYQ, por sus siglas en inglés). Han sido 100 años desde la publicación del artículo con el que Werner Heisenberg alumbró una nueva mecánica para el mundo atómico. Fue el primero de una serie de trabajos, escritos por él y otros autores —entre los que se encuentran, por ejemplo, Erwin Schrödinger, Max Born, Pascual Jordan, Paul A. Dirac y Wolfgang Pauli— con los que erigieron de forma coral la mecánica cuántica.

Esta «celebración» reconoce que la ciencia cuántica ha ido influyendo en nuestra vida cotidiana de formas invisibles pero esenciales. Dio lugar a los semiconductores y a los láseres, por citar unos pocos de los cambios que han impulsado.

En el terreno de la Computación Cuántica, 2025 significó un marco de anuncios relevantes: Procesadores cuánticos más estables, con miles de qubits coherentes, permitieron simulaciones que superan en algunas tareas a los superordenadores clásicos, corrigiendo errores (ruido cuántico) que antes limitaban su utilidad.

Empresas como IBM, Google y startups especializadas demostraron aplicaciones reales en optimización logística. Eventos globales, conferencias y campañas de divulgación, como las organizadas por la UNESCO, destacaron el potencial de la cuántica para abordar desafíos como la ciberseguridad, convirtiendo 2025 en un catalizador para la «segunda revolución cuántica».

Sin embargo, este entusiasmo no oculta algunas sombras: la posibilidad de descifrar claves utilizadas en la criptografía actual.

Desde ese punto de vista, la computación cuántica no es una amenaza hipotética; es una realidad en evolución que pone en jaque los sistemas criptográficos que protegen datos sensibles en empresas de todo el mundo. Los algoritmos tradicionales, como RSA y ECC (Elliptic Curve Cryptography), se basan en problemas matemáticos difíciles para computadoras clásicas, como factorizar (encontrar los números primos que multiplicados dan la cifra) números grandes. Sin embargo, el algoritmo de Shor, propuesto en 1994, permite a una computadora cuántica resolver estos problemas mucho más rápido, rompiendo el cifrado en dias en lugar de millones de años.

Entre los riesgos más críticos destacan:

- «Harvest Now, Decrypt Later» (Recolecta ahora, descifra después): Sistemas de inteligencia militar de otros países o ciberdelincuentes ya están recolectando datos cifrados hoy, esperando el momento en que las computadoras cuánticas escalables estén disponibles para descifrarlos. Según estimaciones de diferentes analistas del mercado, la criptografía asimétrica podría volverse vulnerable hacia 2030 y poco útil para 2035. Esto afecta a datos que requieren disponibilidad a largo plazo, como registros médicos, financieros o secretos industriales.

- Vulnerabilidades en Infraestructuras Críticas: Sectores como banca, salud y cloud computing dependen de protocolos como TLS, para el cifrado de las comunicaciones que dejarían de ser útiles si nos se cambia el tipo de criptografía. Estimaciones recientes señalan que a lo sumo el 3% de las organizaciones ha implementado medidas de resistencia cuántica, dejando expuestas a la mayoría. En España, normativas como el Esquema Nacional de Seguridad (ENS) y el RGPD exigen protección de datos, pero muchas empresas subestiman el riesgo, con solo el 4% de líderes viéndolo como inminente en los próximos tres años.

- Impacto Económico y Regulatorio: La transición tardía podría suponer ingentes pérdidas económicas por las nuevas brechas de seguridad.

En el lado positivo, ya existen estándares como los definidos por el NIST (National Institute of Standards and Technology) de Estados Unidos (con amplio consenso internacional) que describen en detalle los algoritmos PQC como CRYSTALS-Kyber y CRYSTALS-Dilithium, Sphincs+ y Falcon urgiendo a las empresas a adoptarlos para cumplir con regulaciones futuras.

Recientes avances en computación cuántica, como qubits más estables, aceleraron las expectativas de evolución del hardware haciendo imperativa una acción inmediata.

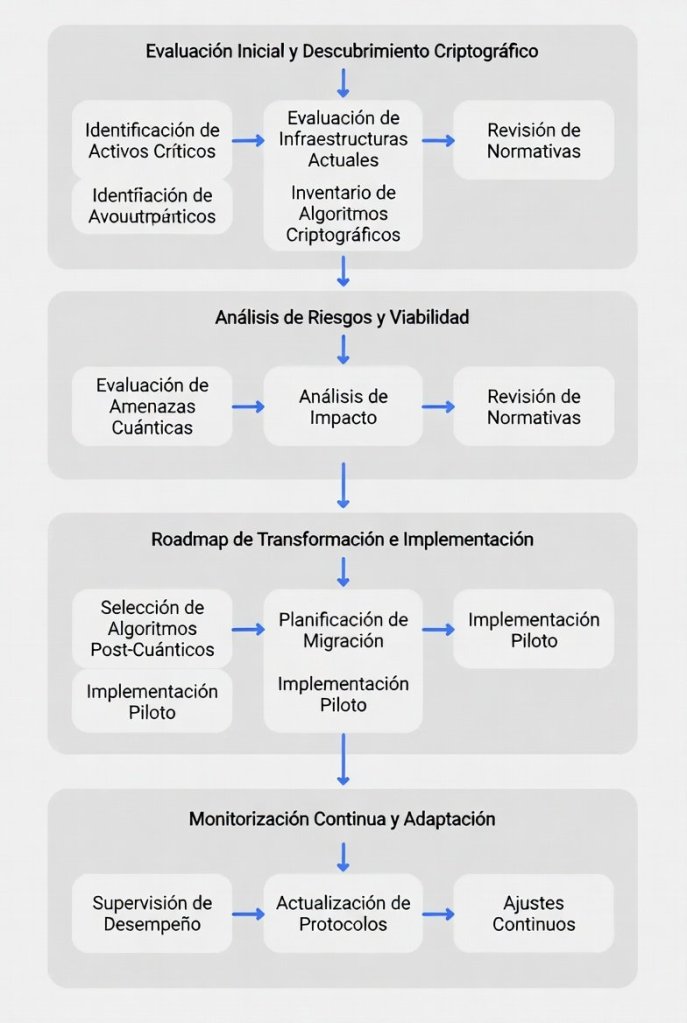

Metodología de EADTrust

En EADTrust, nuestra consultoría de análisis de riesgo cuántico se diseña para ser práctica y escalable, alineada con normativas europeas y españolas como el ENS, ENI y RGPD.

Se estructura en fases que transforman la criptografía desde un «enigma técnico» a un activo estratégico.

- Evaluación Inicial y Descubrimiento Criptográfico: Comenzamos con un diagnóstico exhaustivo del ecosistema digital de la empresa. Usando herramientas avanzadas, identificamos todos los activos criptográficos (claves, certificados, protocolos) en sistemas, clouds y aplicaciones. Esto incluye la creación de un Cryptographic Bill of Materials (CBOM), un inventario detallado que mapea vulnerabilidades cuánticas, priorizando datos sensibles por su valor y duración de protección necesaria.

- Análisis de Riesgos y Viabilidad: Evaluamos el impacto potencial mediante escenarios como «harvest now, decrypt later». Realizamos pruebas de viabilidad con algoritmos PQC estandarizados por NIST, cuantificando riesgos basados en activos (e.g., ¿qué pasaría si se rompe el cifrado de una base de datos de clientes?). Incorporamos principios de «cripto-agilidad» para permitir actualizaciones sin interrupciones operativas.

- Roadmap de Transformación e Implementación: Desarrollamos un plan personalizado para la transición a PQC. Esto incluye integración con marcos como Zero Trust, donde se aplican verificaciones continuas y mínimo privilegio. Recomendamos soluciones híbridas (clásica + post-cuántica) para una migración gradual, junto con formación para equipos. Finalmente, ofrecemos auditorías de cumplimiento para asegurar alineación con regulaciones.

- Monitorización Continus y Adaptación: La consultoría no termina en la implementación; incluimos revisiones periódicas para adaptarse a evoluciones en amenazas cuánticas, garantizando resiliencia a largo plazo.

Esta metodología no solo mitiga riesgos, sino que posiciona a las empresas como líderes en innovación, convirtiendo la amenaza cuántica en una oportunidad.

Nuestra propuesta añade un énfasis en el cumplimiento de la normativa europea y española, facilitando una comprensión accesible del mundo cuántico para decisores no técnicos.

2025 nos recordó que la fisca cuántica no es ciencia ficción, sino una fuerza transformadora también en el campo de la computación que exige preparación inmediata. Si tu empresa maneja datos críticos, contacta con EADTrust para un análisis inicial. La transición a la post-cuántica no es opcional; es esencial para sobrevivir en la era digital que se avecina. Llámanos al +34 91 716 0555 (desde España, también al 902 365 612).